Compute

O compute do Databricks se refere à seleção de recursos de compute disponíveis no workspace do Databricks. Os usuários precisam ter acesso ao compute para executar cargas de trabalho de engenharia de dados, ciência de dados e análise de dados, como pipelines de ETL de produção, análise de streaming, análise ad-hoc e machine learning.

Os usuários podem se conectar ao compute existente ou criar um novo compute se tiverem as permissões adequadas.

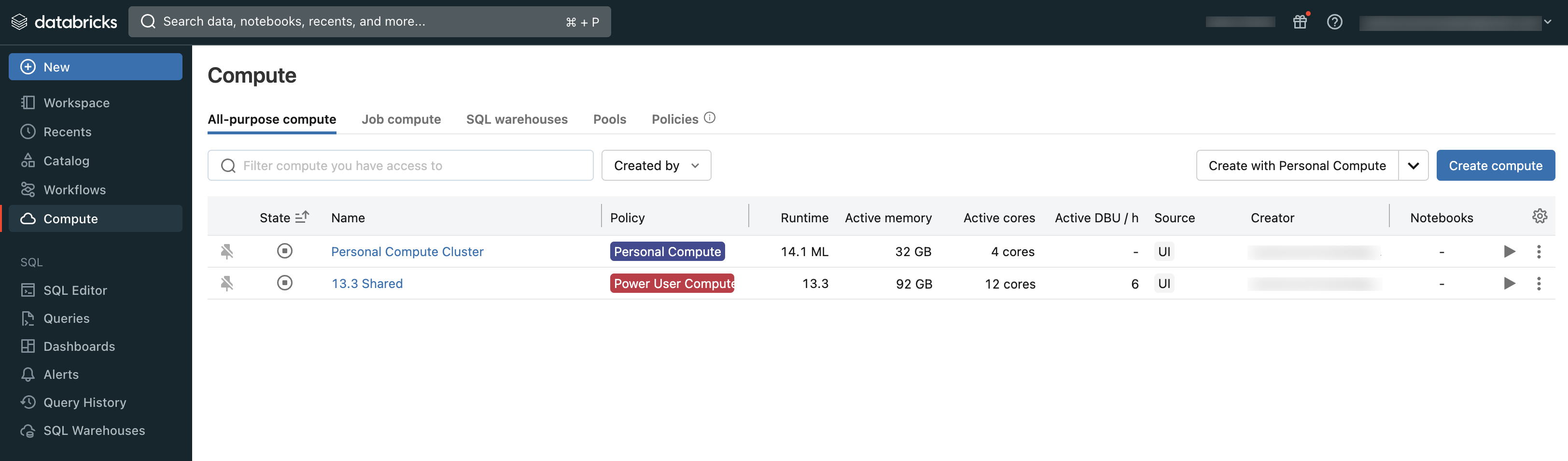

Você pode exibir o compute ao qual tem acesso usando a seção Compute do workspace:

Tipos de compute

Estes são os tipos de compute disponíveis no Databricks:

All-purpose compute: provisionamento compute usado para analisar dados no Notebook. O senhor pode criar, encerrar e reiniciar esse compute usando a interface do usuário, CLI, ou REST API.

Jobs compute: provisionamento compute usado para executar o Job automatizado. O programador de trabalho Databricks cria automaticamente um trabalho compute sempre que um trabalho é configurado para ser executado em um novo compute. O site compute é encerrado quando o trabalho é concluído. O senhor não pode reiniciar um trabalho compute. Consulte Configurar compute para o trabalho.

Pool de instâncias: computação com instâncias paradas e prontas para uso, usadas para reduzir o tempo de início e de autoescala. O senhor pode criar esse compute usando a interface do usuário, CLI, ou REST API.

sem servidor SQL warehouse (Public Preview)): Elástico sob demanda compute usado para executar SQL comando em objetos de dados no editor SQL ou no Notebook interativo. O senhor pode criar o depósito SQL usando a interface do usuário, CLI, ou REST API.

Armazém clássico SQL: Usado para executar SQL comando em objetos de dados no editor SQL ou no Notebook interativo. O senhor pode criar o depósito SQL usando a interface do usuário, CLI, ou REST API.

Os artigos nesta seção descrevem como trabalhar com recursos de compute usando a interface do usuário do Databricks. Para outros métodos, consulte O que é a CLI do Databricks? e a referência da API REST do Databricks.

Databricks Runtime

O Databricks Runtime é o conjunto de componentes principais executados em seu compute. O Databricks Runtime é uma configuração personalizável em clusters de compute para todos os fins ou jobs, mas é selecionada automaticamente em SQL warehouses.

Cada versão do Databricks Runtime inclui atualizações que melhoram a usabilidade, o desempenho e a segurança da análise de big data. O Databricks Runtime em seu compute adiciona muitos recursos, incluindo:

Delta Lake, uma camada de armazenamento de última geração criada sobre o Apache Spark que fornece transações ACID, layouts e índices otimizados e melhorias no mecanismo de execução para a criação de pipelines de dados. Veja O que é Delta Lake?.

Bibliotecas Java, Scala, Python e R instaladas.

Ubuntu e suas bibliotecas de sistema que o acompanham.

Bibliotecas de GPU para clusters ativados para GPU.

Serviços do Databricks que se integram a outros componentes da plataforma, como notebooks, trabalhos e gerenciamento de clusters.

Para obter informações sobre o conteúdo de cada versão de tempo de execução, consulte as notas sobre a versão.

Controle de versão em tempo de execução

Versões do Databricks Runtime são lançadas regularmente:

As versões de suporte de longo prazo são representadas por um qualificador LTS (por exemplo, 3.5 LTS). Para cada versão principal, declaramos uma versão de recurso “canônica”, para a qual fornecemos três anos completos de suporte. Consulte Ciclos de vida de suporte do Databricks para obter mais informações.

As versões principais são representadas por um incremento no número da versão que precede o ponto decimal (o salto de 3.5 para 4.0, por exemplo). Eles são lançados quando há grandes mudanças, algumas das quais podem não ser compatíveis com as versões anteriores.

As versões de recursos são representadas por um incremento no número da versão após o ponto decimal (por exemplo, a mudança de 3.4 para 3.5). Cada versão principal inclui várias versões de recursos. As versões de recursos são sempre compatíveis com versões anteriores dentro da mesma versão principal