O que está por vir?

Saiba mais sobre as mudanças de recurso e comportamento nas próximas versões do site Databricks.

Publique em vários catálogos e esquemas em Unity Catalog a partir de seu pipeline Delta Live Tables

Uma versão futura do Delta Live Tables incluirá funcionalidade aprimorada para publicação e leitura do conjunto de dados do pipeline:

Ao publicar tabelas no Unity Catalog a partir de um único pipeline, o senhor não estará mais restrito à especificação de um único catálogo e esquema. Em vez disso, o senhor poderá publicar em vários catálogos e esquemas a partir de um único pipeline, especificando nomes de tabelas totalmente qualificados (

catalog.schema.table).A sintaxe

USE CATALOGeUSE SCHEMAtambém será suportada.Não será mais necessário usar a palavra-chave

LIVEpara fazer referência ao conjunto de dados interno.

Essa é uma mudança ininterrupta. Essa nova funcionalidade será aplicada quando o senhor criar um novo Delta Live Tables pipeline, mas o pipeline existente continuará a ser executado usando a configuração atual.

Mudança de comportamento quando as definições de conjunto de dados são removidas de um pipeline do Delta Live Tables

Uma versão futura do Delta Live Tables mudará o comportamento quando uma tabela materializada view ou de transmissão for removida de um pipeline. Com essa alteração, a tabela materializada view ou de transmissão removida não será excluída automaticamente na próxima execução da atualização pipeline. Em vez disso, o senhor poderá usar o comando DROP MATERIALIZED VIEW para excluir uma tabela materializada view ou o comando DROP TABLE para excluir uma tabela de transmissão. Após a queda de um objeto, a execução de uma atualização do pipeline não recuperará o objeto automaticamente. Um novo objeto é criado se uma tabela materializada view ou de transmissão com a mesma definição for adicionada novamente ao pipeline. O senhor pode, no entanto, recuperar um objeto usando o comando UNDROP.

ipynb Notebook se tornará o formato default Notebook para Databricks

Atualmente, o Databricks cria todos os novos notebooks no "formato de fonteDatabricks " pelo default, que captura apenas o código. Em janeiro de 2025, o novo formato do default Notebook será ipynb (.ipynb), que também captura o ambiente do Notebook, as definições de visualização e os widgets do Notebook. Esse novo default pode ser alterado no painel workspace user Settings (Configurações do usuário). Para obter mais detalhes sobre os formatos do Notebook, consulte Notebook formats.

Os arquivos do espaço de trabalho serão ativados para todos os espaços de trabalho do Databricks em 1º de fevereiro de 2025

Databricks habilitará os arquivos workspace para todo o espaço de trabalho Databricks em 1º de fevereiro de 2025. Essa alteração desbloqueia os usuários do site workspace de usar o novo recurso de arquivo workspace. Após 1º de fevereiro de 2025, o senhor não poderá desativar workspace os arquivos usando a enableWorkspaceFilesystem propriedade com o Databricks REST API recurso para ativar e desativar workspace o recurso. Para obter mais detalhes sobre os arquivos workspace, consulte O que são arquivos workspace?

Alterações no suporte à versão antiga do painel

Databricks recomenda o uso do AI/BI dashboards (anteriormente Lakeview dashboards). As versões anteriores dos painéis, anteriormente chamadas de Databricks SQL dashboards, agora são chamadas de legacy dashboards. A Databricks não recomenda a criação de novos painéis legados. AI/BI Os painéis oferecem recursos aprimorados em comparação com a versão anterior, incluindo a criação assistida pelo site AI, modos de rascunho e publicação e filtragem cruzada.

Cronograma de fim do suporte para painéis antigos

7 de abril de 2025: o suporte oficial para a versão antiga dos painéis será encerrado. Somente problemas críticos de segurança e interrupções de serviço serão abordados.

3 de novembro de 2025: A Databricks começará a arquivar painéis legados que não foram acessados nos últimos seis meses. Os painéis arquivados não estarão mais acessíveis e o processo de arquivamento ocorrerá de forma contínua. O acesso aos painéis usados ativamente permanecerá inalterado.

A Databricks trabalhará com os clientes para desenvolver planos de migração para painéis legados ativos após 3 de novembro de 2025.

Para ajudar na transição para os painéis AI/BI, as ferramentas de atualização estão disponíveis tanto na interface do usuário quanto no API. Para obter instruções sobre como usar a ferramenta de migração integrada na interface do usuário, consulte Clonar um painel legado para um AI/BI dashboard. Para obter um tutorial sobre como criar e gerenciar painéis usando o REST API em Use Databricks APIs para gerenciar painéis.

O campo sourceIpAddress nos registros de auditoria não incluirá mais um número de porta

Devido a um bug, algumas auditorias de autorização e autenticação logs incluem um número de porta além do IP no campo sourceIPAddress (por exemplo, "sourceIPAddress":"10.2.91.100:0"). O número da porta, que é registrado como 0, não fornece nenhum valor real e é inconsistente com o restante da auditoria Databricks logs. Para melhorar a consistência da auditoria logs, Databricks planeja alterar o formato do endereço IP para esses eventos de auditoria log. Essa alteração será implementada gradualmente a partir do início de agosto de 2024.

Se a auditoria log contiver um sourceIpAddress de 0.0.0.0, Databricks poderá parar de registrar.

A integração legada do Git termina em 31 de janeiro

Após 31 de janeiro de 2024, o site Databricks removerá as integrações legadas do site Notebook Git . Esse recurso está no status de legado há mais de dois anos, e um aviso de descontinuidade é exibido na interface do usuário do produto desde novembro de 2023.

Para obter detalhes sobre a migração para as pastas do Databricks Git (anteriormente Repos) a partir da integração do Git legado, consulte Mudança para o Databricks Repos a partir da integração do Git legado. Se essa remoção afetar o senhor e precisar de uma extensão, entre em contato com a equipe Databricks account .

O envio de tíquetes de suporte externo será descontinuado em breve

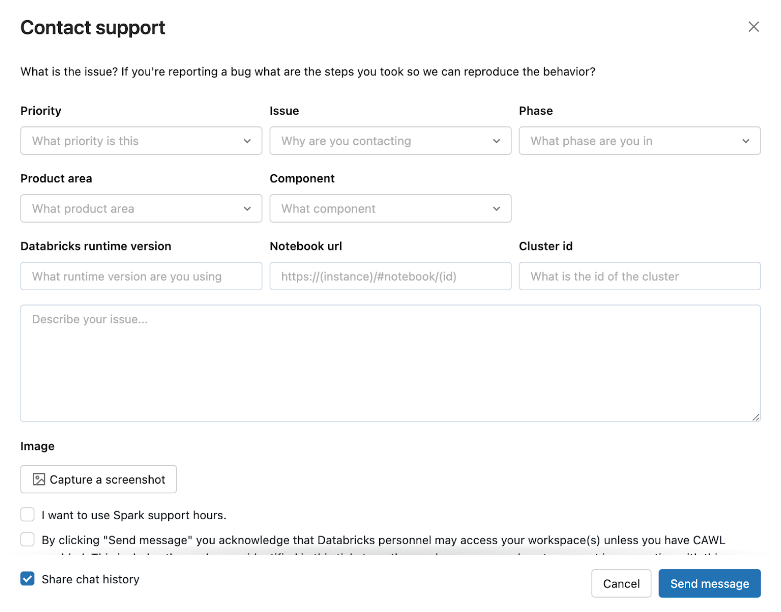

Databricks está fazendo a transição da experiência de envio de tíquetes de suporte de help.databricks.com para o menu de ajuda no site Databricks workspace. O envio de tíquetes de suporte via help.databricks.com será descontinuado em breve. O senhor continuará acessando view e fazendo a triagem de seus tíquetes em help.databricks.com.

A experiência no produto, que está disponível se a sua organização tiver um contrato de suporte do Databricks, integra-se ao Databricks Assistant para ajudar a resolver os seus problemas rapidamente, sem ter de submeter um bilhete.

Para acessar a experiência in-produto, clique no ícone do usuário na barra superior do site workspace e, em seguida, clique em Contact Support ou digite "I need help" (Preciso de ajuda) no assistente.

O modal Contate o suporte é aberto.

Se a experiência do produto falhar, envie solicitações de suporte com informações detalhadas sobre o seu problema para ajudar@databricks.com. Para obter mais informações, consulte Obter ajuda.

JDK8 e JDK11 não serão suportados

O Databricks planeja remover o suporte ao JDK 8 com a próxima versão principal do Databricks Runtime, quando o Spark 4.0 for lançado. A Databricks planeja remover o suporte ao JDK 11 com a próxima versão LTS do Databricks Runtime 14.x.

Ativação automática do Unity Catalog para novos espaços de trabalho

Databricks começou a ativar o Unity Catalog automaticamente para novos espaços de trabalho. Isso elimina a necessidade de os administradores do account configurarem o Unity Catalog depois que um workspace é criado. A implantação está ocorrendo gradualmente em toda a conta.

atualização sqlite-jdbc

O Databricks Runtime planeja atualizar a versão sqlite-jdbc de 3.8.11.2 para 3.42.0.0 em todas as versões de manutenção do Databricks Runtime. As APIs da versão 3.42.0.0 não são totalmente compatíveis com a 3.8.11.2. Confirme que seus métodos e tipo de retorno utilizem a versão 3.42.0.0.

Se você estiver usando sqlite-jdbc em seu código, verifique o relatório de compatibilidade sqlite-jdbc.