Configurar compute para o trabalho

Este artigo contém recomendações e recursos para configurar o site compute para Databricks Jobs.

Importante

As limitações do site serverless compute for Job incluem o seguinte:

Não há suporte para programação contínua.

Não há suporte para default ou acionadores de intervalos baseados em tempo na transmissão estruturada.

Para obter mais limitações, consulte Limitações da computação sem servidor.

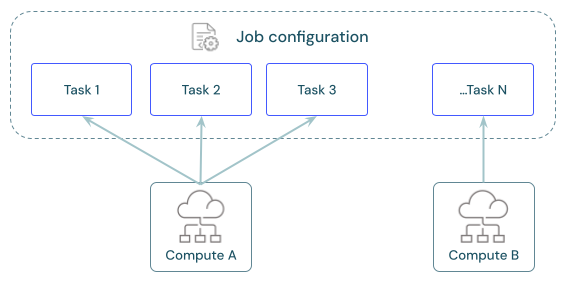

Cada trabalho pode ter uma ou mais tarefas. O senhor define compute recurso para cada tarefa. Várias tarefas definidas para o mesmo trabalho podem usar o mesmo recurso compute.

Qual é a computação recomendada para cada tarefa?

A tabela a seguir indica os tipos de compute recomendados e suportados para cada tipo de tarefa.

Tarefa |

Recomendado compute |

Com suporte compute |

|---|---|---|

Notebooks |

Trabalho clássico |

Trabalho clássico, clássico para todos os fins |

Script Python |

Trabalho clássico |

Trabalho clássico, clássico para todos os fins |

Python Wheel |

Trabalho clássico |

Trabalho clássico, clássico para todos os fins |

dbt |

sem servidor SQL warehouse |

sem servidor SQL warehouse, pro SQL warehouse |

dbt CLI comando |

Trabalho clássico, clássico para todos os fins |

|

JAR |

Trabalho clássico |

Trabalho clássico, clássico para todos os fins |

Spark Submit |

Trabalho clássico |

Trabalho clássico |

preços for Jobs está vinculado ao site compute usado para executar a tarefa. Para obter mais detalhes, consulte Databricks preços.

Como faço para configurar a computação para Jobs?

O Jobs compute é configurado diretamente na UI do Databricks Jobs. Essas configurações fazem parte da definição do trabalho. Todos os outros tipos de compute disponíveis armazenam suas configurações com outros workspace ativos, conforme descrito na tabela a seguir:

Tipo de Compute |

Detalhes |

|---|---|

Empregos compute |

O senhor configura o compute for Job usando a mesma interface do usuário e as mesmas configurações disponíveis para o compute para todos os fins. Consulte Referência de configuração do Compute. |

SQL warehouses |

serverless e pro SQL warehouse são configurados por administradores do workspace ou usuários com privilégios irrestritos de criação do cluster. O senhor configura a tarefa para execução no site SQL warehouse existente. Consulte Conectar-se a um site SQL warehouse. |

Delta Live Tables pipeline compute |

O senhor define as configurações do compute para o pipeline Delta Live Tables durante a configuração do pipeline. Consulte Configurar a computação para um pipeline do Delta Live Tables. |

Compute para todos os fins |

Opcionalmente, o senhor pode configurar a tarefa em relação ao clássico compute. Databricks não recomenda essa configuração para trabalhos de produção. Consulte a referência de configuração de computação e O site compute para todos os fins deve ser usado para trabalhos? |

Revisar, configurar e swap Job compute

A seção de computação no painel de detalhes doJob lista todos os compute configurados para tarefa no trabalho atual.

A tarefa configurada para usar um recurso compute é destacada no gráfico da tarefa quando o senhor passa o mouse sobre a especificação compute.

Use o botão de troca para alterar o endereço compute para todas as tarefas associadas a um recurso compute.

O trabalho clássico compute recurso tem uma opção Configure (Configurar ). Outros compute recursos oferecem ao senhor opções para view e modificar compute detalhes de configuração.

Recomendações para a configuração do Job clássico compute

Esta seção concentra-se em recomendações gerais sobre recursos e configurações que podem beneficiar alguns fluxos de trabalho. As recomendações específicas para configurar o tamanho e os tipos de compute recurso variam de acordo com a carga de trabalho.

Databricks O senhor recomenda habilitar o Photon Acceleration, usar versões recentes do Databricks Runtime e usar o compute configurado para Unity Catalog.

Observação

transmissão estructurada fluxo de trabalho têm recomendações específicas. Consulte Considerações sobre produção para transmissão estruturada.

Use a política de cluster

Databricks recomenda que os administradores do workspace definam políticas de cluster para o Job e apliquem essas políticas a todos os usuários que configuram o Job.

política de cluster permitem que os administradores do workspace definam controles de custo e limitem as opções de configuração dos usuários. Para obter detalhes sobre a configuração da política de cluster, consulte Criar e gerenciar políticas de compute .

Databricks fornece uma política default configurada para o Job. Os administradores podem tornar essa política disponível para outros usuários do site workspace. Consulte Job compute.

Usar a escala automática

Configure o autoscale para que a tarefa de longa duração possa adicionar e remover dinamicamente os nós do worker durante a execução do trabalho. Consulte Ativar escala automática.

Use o site pool para reduzir o tempo de cluster começar

permitem que o senhor reserve compute recurso do seu provedor cloud. O pool é benéfico para reduzir o tempo do novo trabalho cluster começar e garantir a disponibilidade do recurso compute. Consulte a referência de configuração do pool.

Use instâncias preemptivas

Configure instâncias preemptivas para cargas de trabalho com requisitos de latência flexíveis para otimizar os custos. Consulte Instâncias preemptivas.

Configurar zonas de disponibilidade

Especifique uma zona de disponibilidade (AZ) se sua organização tiver comprado instâncias reservadas. Consulte as zonas de disponibilidade.

O site compute deve ser usado para todos os fins no trabalho?

Há vários motivos pelos quais o site Databricks recomenda não usar o site compute para todos os fins no trabalho, incluindo os seguintes:

Databricks O senhor paga pelo site compute em uma taxa diferente do Job compute.

Jobs compute é encerrado automaticamente após a conclusão da execução de um trabalho. O site compute para todos os fins oferece suporte ao encerramento automático, que está vinculado à inatividade e não ao fim da execução de um trabalho.

O site compute para todos os fins é frequentemente compartilhado entre equipes de usuários. Os trabalhos agendados em compute para todos os fins geralmente têm latência aumentada devido à concorrência pelo recurso compute.

Muitas recomendações para otimizar a configuração do Job compute não são apropriadas para o tipo de consultas ad-hoc e cargas de trabalho interativas executadas em compute.

Veja a seguir os casos de uso em que o senhor pode optar por usar o site compute para todos os fins:

O senhor está desenvolvendo ou testando iterativamente um novo trabalho. Os tempos de inicialização do Job compute podem tornar o desenvolvimento iterativo tedioso. O site compute permite que o senhor aplique alterações e execute seu trabalho rapidamente.

O senhor tem um trabalho de curta duração que deve ser executado com frequência ou em uma programação específica. Não há tempo de start-up associado ao site de uso geral em execução no momento compute. Considere os custos associados ao tempo de parada se estiver usando esse padrão.