Diagnosticando um estágio longo no Spark

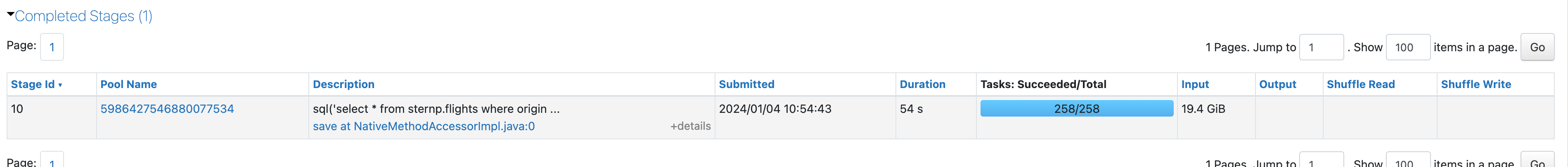

começar identificando o estágio mais longo do Job. Role até a parte inferior da página Jobpara ver a lista de estágios e ordene-os por duração:

Detalhes de E/S do estágio

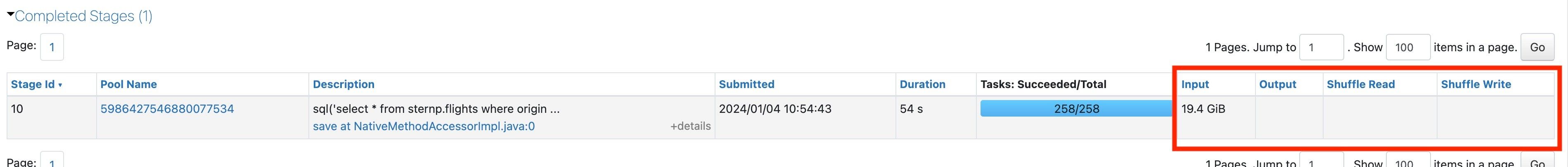

Para ver os dados de alto nível sobre o que esse estágio estava fazendo, observe as colunas Input, Output, leitura aleatória e gravação aleatória:

As colunas significam o seguinte:

Entrada: A quantidade de dados que esse estágio lê do armazenamento. Isso pode ser a leitura de Delta, Parquet, CSV, etc.

Saída: A quantidade de dados que esse estágio gravou no armazenamento. Isso pode ser gravado em Delta, Parquet, CSV, etc.

leitura aleatória: A quantidade de dados embaralhados lidos por esse estágio.

gravação aleatória: A quantidade de dados aleatórios que este estágio escreveu.

Se o senhor não sabe o que é shuffle, agora é um bom momento para aprender o que isso significa.

Anote esses números, pois o senhor provavelmente precisará deles mais tarde.

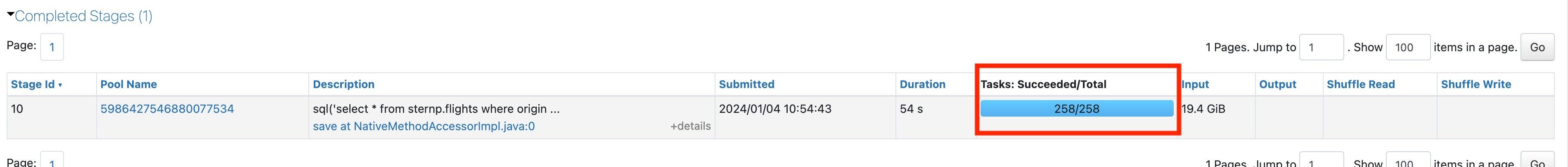

Número de tarefas

O número de tarefas no estágio longo pode indicar ao senhor a direção do seu problema. O senhor pode determinar o número de tarefas olhando aqui:

Se o senhor vir uma tarefa, isso pode ser sinal de um problema. Para obter mais informações, consulte One Spark tarefa.

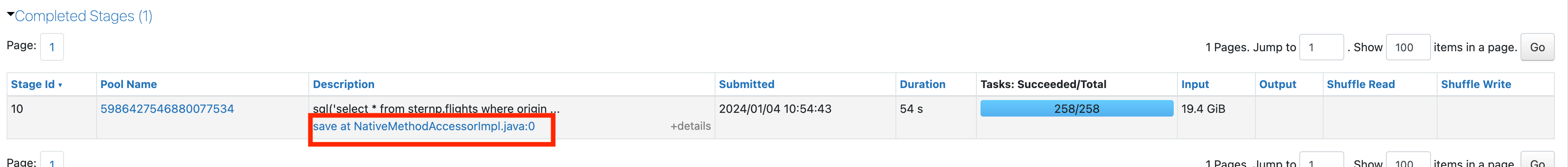

Ver mais detalhes do palco

Se o estágio tiver mais de uma tarefa, o senhor deve investigar mais a fundo. Clique no link na descrição do estágio para obter mais informações sobre o estágio mais longo:

Agora que o senhor está na página do palco, consulte Skew and spill (Inclinação e derramamento).