AI エージェントと ML モデルのライフサイクルを生成するための MLflow

この記事では、MLflow Databricksを使用して、高品質の生成AI エージェントと機械学習モデルを開発する方法について説明します。

注

Databricks を使い始めたばかりの場合は、 Databricks Community Edition で MLflow を試すことを検討してください。

MLflow とは

MLflow は、モデルを開発し、アプリケーションを生成するためのオープンソース プラットフォームAI 。 これには、次の主要コンポーネントがあります。

追跡: エクスペリメントを追跡して、パラメーターと結果を記録および比較できます。

モデル: さまざまな ML ライブラリからさまざまなモデルサービングおよび推論プラットフォームにモデルを管理およびデプロイできます。

Model Registry: モデルのバージョン管理とアノテーション機能を使用して、ステージングから本番運用までのモデルデプロイプロセスを管理できます。

AI エージェントの評価とトレース: エージェントの比較、評価、トラブルシューティングを支援することで、高品質の AI エージェントを開発できます。

Databricks マネージド MLflow

Databricks は、フルマネージドおよびホスト型の MLflow バージョンを提供し、オープンソースのエクスペリエンスに基づいて構築されているため、エンタープライズでの使用に対してより堅牢でスケーラブルなものになっています。

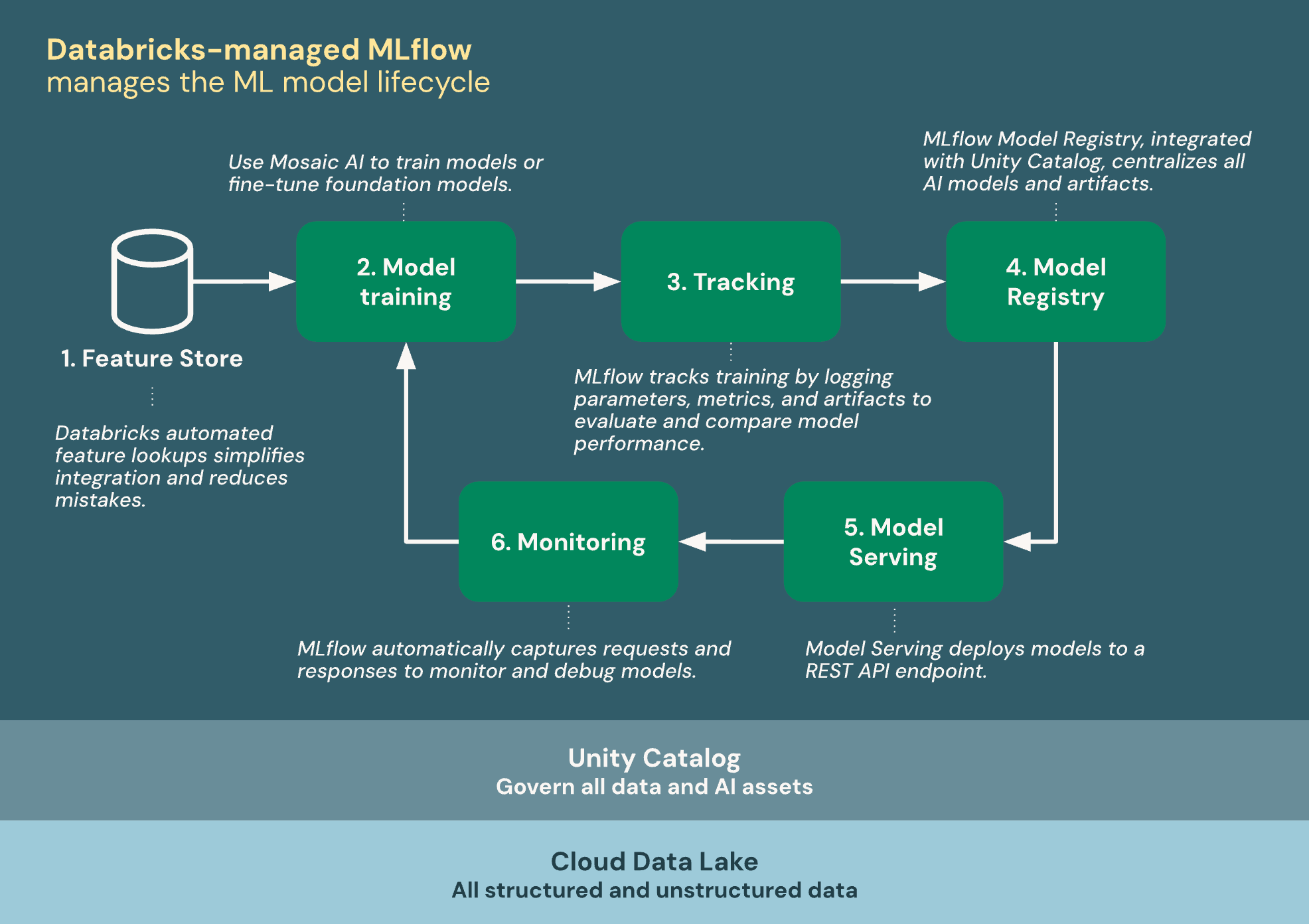

次の図は、Databricks が MLflow と統合して機械学習モデルをトレーニングおよびデプロイする方法を示しています。

DatabricksマネージドMLflow は、Unity Catalog と Cloud データレイクを基盤として構築されており、 ライフサイクル内のすべてのデータと アセットを統合します。AIML

機能ストア: Databricks の自動機能検索により、統合が簡素化され、ミスが減ります。

トレイン モデル:Mosaic AIを使用してモデルをトレーニングしたり、基盤モデルを微調整したりします。

トラッキング: MLflow は、パラメーター、メトリクス、アーティファクトをログに記録してトレーニングを追跡し、モデルのパフォーマンスを評価および比較します。

Model Registry:MLflow Model Registry、Unity Catalogと統合され、AIモデルとアーティファクトを一元化します。

モデルサービング: Mosaic AI Model Serving は、モデルを REST API エンドポイントにデプロイします。

モニタリング: Mosaic AI Model Serving は、モデルの監視とデバッグのためのリクエストとレスポンスを自動的にキャプチャします。 MLflow は、要求ごとにトレース データを使用してこのデータを補強します。

モデルトレーニング

MLflow モデルは、Databricks での AI と ML 開発の中核をなすものです。 MLflow モデルは、機械学習モデルをパッケージ化し、AI エージェントを生成するための標準化された形式です。 標準化された形式により、モデルとエージェントを Databricks のダウンストリーム ツールとワークフローで使用できます。

MLflow のドキュメント - モデル。

Databricks には、さまざまな種類の ML モデルのトレーニングに役立つ機能が用意されています。

エクスペリメント トラッキング

Databricks では MLflow エクスペリメントを組織単位として使用して、モデルの開発中に作業を追跡します。

エクスペリメント追跡を使用すると、機械学習トレーニングおよびエージェント開発中に、パラメーター、メトリクス、アーティファクト、およびコードのバージョンをログに記録および管理できます。 ログをエクスペリメントに整理して実行すると、モデルの比較、パフォーマンスの分析、反復処理が容易になります。

MLflow実行とエクスペリメントの追跡 に関する一般的な情報については、 のドキュメントを参照してください。

Model RegistryとのUnity Catalog

MLflow Model Registry は、モデルデプロイプロセスを管理するための一元化されたモデルリポジトリ、UI、および APIs のセットです。

Databricks は、Model Registry と Unity Catalog を統合して、モデルのガバナンスを一元化します。 Unity Catalog 統合により、ワークスペース全体でモデルにアクセスしたり、モデルのリネージを追跡したり、再利用するモデルを見つけたりすることができます。

MLflowの一般的な情報についてはModel Registry ドキュメントを参照してください。

モデルサービング

Databricks モデルサービングは MLflow Model Registry と緊密に統合されており、 AI モデルのデプロイ、管理、クエリのための統一されたスケーラブルなインターフェイスを提供します。 提供する各モデルは、Web アプリケーションまたはクライアント アプリケーションに統合できる REST API として使用できます。

これらは異なるコンポーネントですが、モデルサービングは、モデルのバージョン管理、依存関係の管理、検証、ガバナンスの処理を MLflow Model Registry に大きく依存しています。

オープンソース vs. Databricks-managed MLflow の機能

一般的な MLflow の概念、 APIs、およびオープンソース版と Databricks管理版で共有される機能については、 MLflow ドキュメントを参照してください。 Databricksマネージド MLflow専用の機能については、Databricksドキュメントを参照してください。

次の表は、オープンソース MLflow と Databricksマネージド MLflow の主な違いと、詳細の学習に役立つドキュメント リンクを示しています。

機能 |

オープンソース MLflow で入手可能 |

Databricks マネージド MLflow での可用性 |

|---|---|---|

セキュリティ |

ユーザーは、独自のセキュリティガバナンスレイヤーを提供する必要があります |

|

災害復旧 |

利用不可 |

|

実験の追跡 |

MLflow Tracking API、Databricks高度なエクスペリメント追跡と統合されています |

|

モデルレジストリ |

||

Unity Catalogの統合 |

Unity Catalog とのオープンソース統合 |

|

モデルのデプロイ |

外部サービスソリューション(SageMaker、Kubernetes、任意のコンテナサービスなど)とのユーザー設定の統合 |

Databricks モデルサービング と外部サービングソリューション |

AIエージェント |

||

暗号化 |

利用不可 |