Connect to Spotfire アナリスト

この記事では、Spotfire アナリストを Databricks クラスターまたは Databricks SQL ウェアハウスと共に使用する方法について説明します。

要件

-

注

セキュリティのベスト プラクティスとして、自動化されたツール、システム、スクリプト、アプリを使用して認証する場合、 Databricksでは、ワークスペース ユーザーではなく、サービス プリンシパルに属する個人のアクセス トークンを使用することをお勧めします。 サービスプリンシパルのトークンを作成するには、 「サービスプリンシパルのトークンの管理」を参照してください。

クラスターの接続の詳細、特に [サーバーのホスト名]、[ ポート]、および [HTTP パス ] の値。 「Databricks コンピュート リソースの接続の詳細を取得する」を参照してください。

接続するステップ

Spotfire アナリストのナビゲーション バーで、プラス記号 (ファイルとデータ) アイコンをクリックし、[ 接続先] をクリックします。

[ Databricks ] を選択し、[ 新しい接続] をクリックします。

[Apache Spark SQL] ダイアログの [全般] タブの [サーバー] に、ステップ 1 の [サーバーのホスト名] フィールドと [ポート] フィールドの値をコロンで区切って入力します。

[ 認証方法] で [ ユーザー名とパスワード] を選択します。

[ユーザー名] に「

token」と入力します。[パスワード] には、ステップ 1 から個人用アクセストークンを入力します。

[ 詳細設定 ] タブの [Thrift] トランスポート モードで、[ HTTP] を選択します。

[HTTP パス ] に、ステップ 1 の HTTP パス フィールド値を入力します。

[ 全般 ] タブで、[ 接続] をクリックします。

接続に成功したら、[ データベース ] ボックスの一覧で使用するデータベースを選択し、[ OK] をクリックします。

分析する Databricks データを選択する

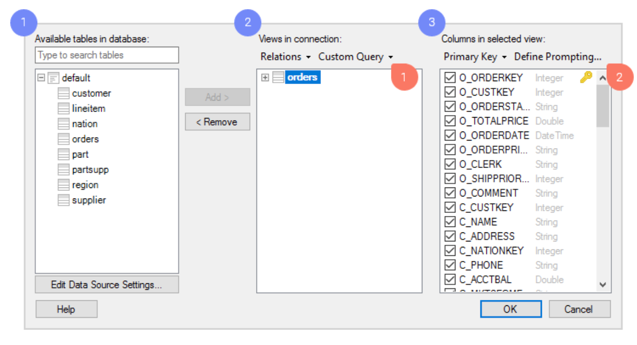

[ 接続のビュー] ダイアログでデータを選択します。

Databricks で使用可能なテーブルを参照します。

ビューとして必要なテーブルを追加します。これが Spotfire で分析するデータ テーブルになります。

ビューごとに、含める列を決定できます。 非常に具体的で柔軟なデータ選択を作成する場合は、このダイアログで次のようなさまざまな強力なツールにアクセスできます。

カスタム クエリー。 カスタム クエリーでは、カスタム SQL クエリーを入力して、分析するデータを選択できます。

プロンプト。 データの選択は、分析ファイルのユーザーに任せます。 プロンプトは、選択した列に基づいて構成します。 その後、分析を開いたエンド ユーザーは、関連する値のみのデータを制限および表示することを選択できます。 たとえば、ユーザーは、特定の期間内または特定の地理的地域のデータを選択できます。

OK をクリックします。

クエリを Databricks にプッシュダウンするか、データをインポートする

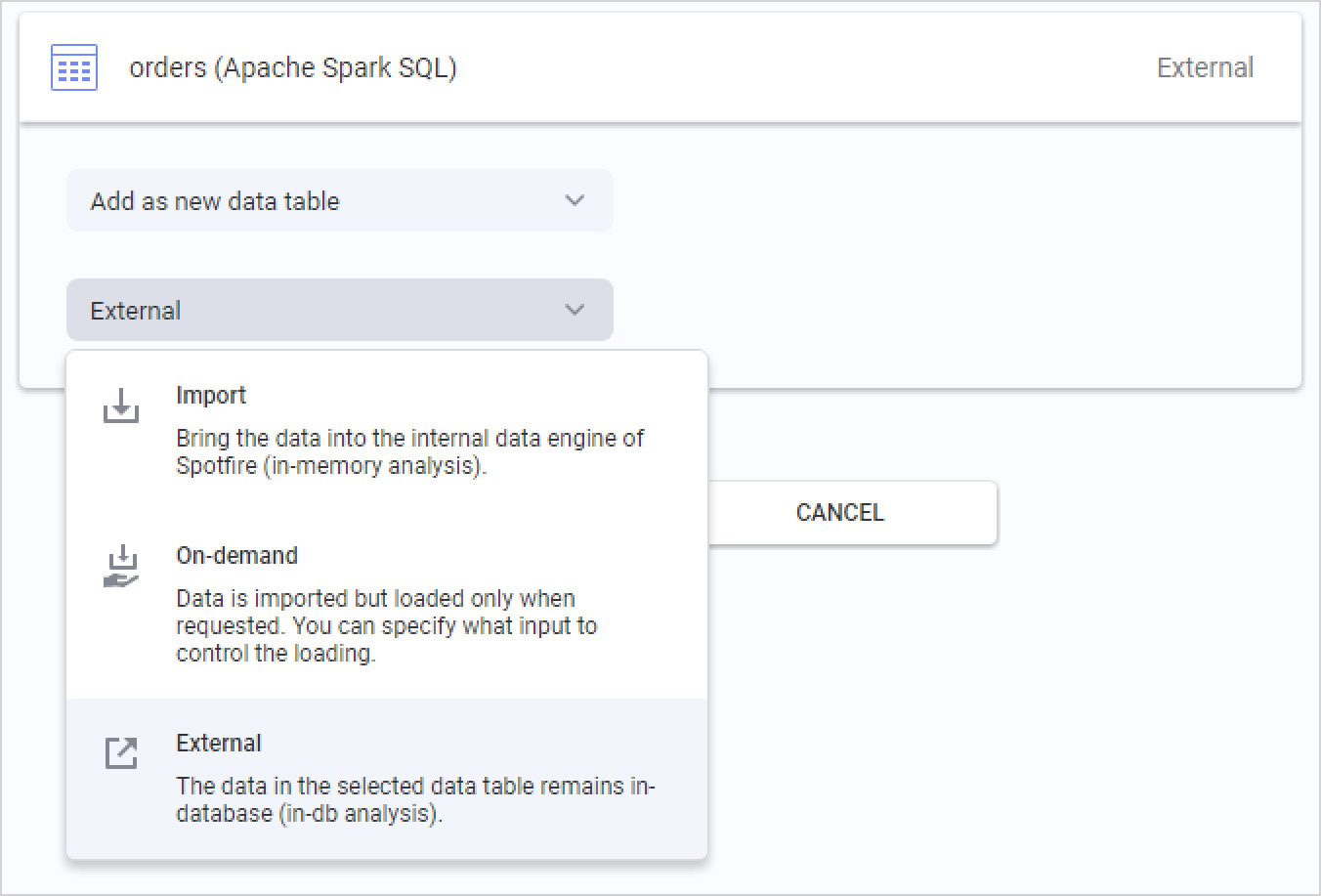

分析するデータを選択したら、最後の手順として、Databricks からデータを取得する方法を選択します。 分析に追加するデータ テーブルの概要が表示され、各テーブルをクリックしてデータの読み込み方法を変更できます。

Databricksのデフォルトオプションは外部です。つまり、データ テーブルは Databricks のデータベース内に保持され、Spotfire は分析でのアクションに基づいて、関連するデータ スライスのさまざまなクエリをデータベースにプッシュします。

また 、[インポート済み] を選択すると、Spotfire がデータ テーブル全体を事前に抽出するため、ローカルのインメモリ分析が可能になります。 データ テーブルをインポートするときは、TIBCO Spotfire の組み込みインメモリ データ エンジンの分析関数も使用します。

3 番目のオプションは On-demand (動的 WHERE 句に対応) で、分析でのユーザー アクションに基づいてデータのスライスが抽出されます。 データのマーキングやフィルター処理、ドキュメント プロパティの変更などのアクションなどの条件を定義できます。 オンデマンド データ ロードは、 外部 データ テーブルと組み合わせることもできます。