Instalar as dependências do Notebook

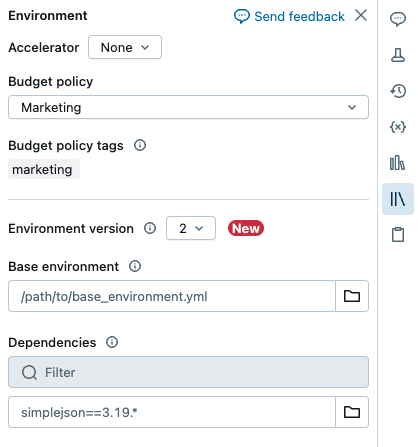

O senhor pode instalar as dependências do Python para o serverless Notebook usando o painel lateral Environment. Esse painel oferece um único local para editar, view e exportar os requisitos de biblioteca do Notebook. Essas dependências podem ser adicionadas usando um ambiente básico ou individualmente.

Para tarefas que não sejamNotebook, consulte Configurar ambientes e dependências para tarefas que não sejamNotebook .

Importante

Não instale o PySpark ou qualquer biblioteca que instale o PySpark como uma dependência do seu notebook serverless. Isso interromperá sua sessão e resultará em um erro. Se isso ocorrer, remova a biblioteca e reinicie seu ambiente.

Configurar um ambiente básico

Um ambiente básico é um arquivo YAML armazenado como um arquivo workspace ou em um volume Unity Catalog que especifica dependências de ambiente adicionais. Os ambientes básicos podem ser compartilhados entre o Notebook. Para configurar um ambiente básico:

Crie um arquivo YAML que defina as configurações de um ambiente virtual Python. O exemplo YAML a seguir, que se baseia na especificação do ambiente de projetos do MLflow, define um ambiente básico com algumas dependências de biblioteca:

client: "1" dependencies: - --index-url https://pypi.org/simple - -r "/Workspace/Shared/requirements.txt" - my-library==6.1 - "/Workspace/Shared/Path/To/simplejson-3.19.3-py3-none-any.whl" - git+https://github.com/databricks/databricks-cli

Carregue o arquivo YAML como um arquivo workspace ou em um volume Unity Catalog. Consulte Importar um arquivo ou Fazer upload de arquivos para um volume do Unity Catalog.

À direita do Notebook, clique no botão

para expandir o painel lateral Environment (Ambiente). Esse botão só aparece quando um Notebook está conectado ao site serverless compute.

para expandir o painel lateral Environment (Ambiente). Esse botão só aparece quando um Notebook está conectado ao site serverless compute.No campo Base Environment (Ambiente básico ), digite o caminho do arquivo YAML de upload ou navegue até ele e selecione-o.

Clique em Apply (Aplicar). Isso instala as dependências no ambiente virtual Notebook e reinicia o processo Python.

Os usuários podem substituir as dependências especificadas no ambiente básico instalando as dependências individualmente.

Configurar o ambiente do Notebook

O senhor também pode instalar dependências em um notebook conectado a serverless compute usando o painel lateral Environment:

À direita do Notebook, clique no botão

para expandir o painel lateral Environment (Ambiente). Esse botão só aparece quando um Notebook está conectado ao site serverless compute.

para expandir o painel lateral Environment (Ambiente). Esse botão só aparece quando um Notebook está conectado ao site serverless compute.Selecione a versão do ambiente no menu suspenso Versão do ambiente. Consulte Versões do ambiente sem servidor. Databricks recomenda escolher a versão mais recente para obter o recurso mais atualizado do Notebook.

Na seção Dependencies (Dependências ), clique em Add Dependency (Adicionar dependência ) e insira o caminho da dependência da biblioteca no campo. O senhor pode especificar uma dependência em qualquer formato que seja válido em um arquivo requirements.txt.

Clique em Apply (Aplicar). Isso instala as dependências no ambiente virtual Notebook e reinicia o processo Python.

Observação

Um trabalho usando serverless compute instalará a especificação de ambiente do Notebook antes de executar o código do Notebook. Isso significa que não há necessidade de adicionar dependências ao programar o Notebook como Job. Consulte Configurar ambientes e dependências.

Exibir as dependências instaladas e os registros do pip

Para view as dependências instaladas, clique em Installed (Instalado ) no painel Environments (Ambientes ) de um Notebook. A instalação do pip logs para o ambiente do Notebook também está disponível clicando em pip logs na parte inferior do painel.

Reset o meio ambiente

Se o Notebook estiver conectado ao site serverless compute, o site Databricks armazena automaticamente em cache o conteúdo do ambiente virtual do Notebook. Isso significa que, em geral, o senhor não precisa reinstalar as dependências do Python especificadas no painel lateral Environment ao abrir um Notebook existente, mesmo que ele tenha sido desconectado devido à inatividade.

Python O cache de ambiente virtual também se aplica ao Job. Quando um trabalho é executado, qualquer tarefa do trabalho que compartilhe o mesmo conjunto de dependências de uma tarefa concluída nessa execução é mais rápida, pois as dependências necessárias já estão disponíveis.

Observação

Se o senhor alterar a implementação de um pacote Python personalizado usado em um trabalho no site serverless, também deverá atualizar o número da versão para que o trabalho possa pegar a implementação mais recente.

Para limpar o cache do ambiente e realizar uma nova instalação das dependências especificadas no painel lateral Environment (Ambiente ) de um Notebook anexado a serverless compute, clique na seta ao lado de Apply (Aplicar ) e, em seguida, clique em Reset environment (Ambiente).

Observação

Reset o ambiente virtual se o senhor instalar um pacote que interrompa ou altere o ambiente principal do Notebook ou do site Apache Spark. A remoção do Notebook do site serverless compute e sua recolocação não necessariamente limpa todo o cache do ambiente. A redefinição do ambiente reinstala todas as dependências especificadas no painel lateral Environment, portanto, certifique-se de que o pacote ofensivo seja removido antes da redefinição.

Configurar ambientes e dependências para nãoNotebook tarefa

Para outros tipos de tarefas compatíveis, como Python script, Python wheel ou dbt tarefa, um ambiente default inclui a instalação da Python biblioteca. Para ver a lista de bibliotecas instaladas, consulte a seção Installed Python biblioteca da versão do cliente que está usando. Consulte Versões do ambiente sem servidor. Se uma tarefa exigir uma Python biblioteca que não esteja instalada, o senhor poderá instalar a biblioteca a partir de workspace arquivos, Unity Catalog volumes ou repositórios públicos de pacotes. Para adicionar uma biblioteca quando o senhor criar ou editar uma tarefa:

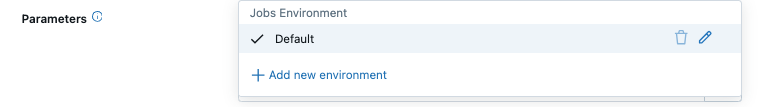

No menu Environment and library (Ambiente e biblioteca ) dropdown, clique em

ao lado do ambiente ou clique em + Add new environment (Adicionar novo ambiente). default ambiente ou clique em + Add new environment (Adicionar novo ambiente).

ao lado do ambiente ou clique em + Add new environment (Adicionar novo ambiente). default ambiente ou clique em + Add new environment (Adicionar novo ambiente).

Selecione a versão do ambiente no menu suspenso Versão do ambiente. Consulte Versões do ambiente sem servidor. Databricks recomenda escolher a versão mais recente para obter o recurso mais atualizado.

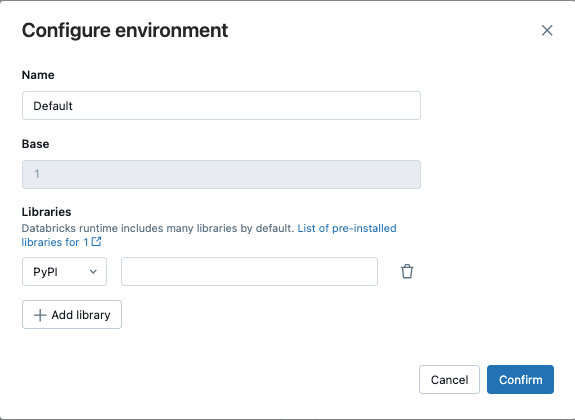

Na caixa de diálogo Configurar ambiente, clique em + Adicionar biblioteca.

Selecione o tipo de dependência no menu dropdown em biblioteca.

Na caixa de texto File Path (Caminho do arquivo ), digite o caminho para a biblioteca.

Para um Python wheel em um arquivo workspace, o caminho deve ser absoluto e começar com

/Workspace/.Para um Python wheel em um volume Unity Catalog, o caminho deve ser

/Volumes/<catalog>/<schema>/<volume>/<path>.whl.Para um arquivo

requirements.txt, selecione PyPi e digite-r /path/to/requirements.txt.

Clique em Confirm (Confirmar ) ou + Add library (Adicionar biblioteca ) para adicionar outra biblioteca.

Se estiver adicionando uma tarefa, clique em Create task (Criar tarefa). Se estiver editando uma tarefa, clique em Save task (Salvar tarefa).

Configure os repositórios default Python pacote

Os administradores podem configurar repositórios pacote privados ou autenticados no espaço de trabalho como a configuração default pip para serverless Notebook e serverless Job. Isso permite que os usuários instalem o pacote a partir de repositórios internos do Python sem definir explicitamente index-url ou extra-index-url. No entanto, se esses valores forem especificados no código ou em um Notebook, eles terão precedência sobre o padrão workspace.

Essa configuração aproveita os segredos do Databricks para armazenar e gerenciar com segurança os URLs e as credenciais do repositório. Os administradores podem fazer a configuração usando a página de configurações de workspace administração ou usando um escopo secreto predefinido e o comando Databricks CLI secrets ou REST API o comando.

Configuração usando a página de configurações de administração do espaço de trabalho

Os administradores do espaço de trabalho podem adicionar ou remover os repositórios do pacote default Python usando a página de configurações de administração workspace.

Como administrador do workspace, log in para o Databricks workspace.

Clique no seu nome de usuário na barra superior do workspace do Databricks e selecione Configurações.

Clique em computar tab.

Ao lado de Pacote Repositories padrão, clique em gerenciar.

(Opcional) Adicione ou remova um URL de índice, URLs de índice extras ou um certificado SSL personalizado.

Clique em Salvar para salvar as alterações.

Observação

As modificações ou exclusões de segredos são aplicadas depois que o senhor anexa novamente o site serverless compute ao Notebook ou executa novamente o trabalho serverless.

Configuração usando a CLI de segredos ou a API REST

Para configurar os repositórios de pacotes default Python usando o CLI ou REST API, crie um escopo secreto predefinido e configure as permissões de acesso e, em seguida, adicione os segredos do repositório de pacotes.

Nome do escopo secreto predefinido

Os administradores do espaço de trabalho podem definir URLs de índice de pip default ou URLs de índice extras juntamente com a autenticação tokens e segredos em um escopo secreto designado sob uma chave predefinida:

Nome do escopo secreto:

databricks-package-managementchave secreta para index-url:

pip-index-urlchave secreta para urnas extra-indexadas:

pip-extra-index-urlschave secreta para o conteúdo da certificação SSL:

pip-cert

Criar o escopo secreto

Um escopo secreto pode ser criado usando o Databricks CLI comando secrets ou REST API o comando. Depois de criar o Secret Scope, configure as listas de controle de acesso para conceder acesso de leitura a todos os usuários do workspace. Isso garante que o repositório permaneça seguro e não possa ser alterado por usuários individuais. O escopo secreto deve usar o nome predefinido de escopo secreto databricks-package-management.

databricks secrets create-scope databricks-package-management

databricks secrets put-acl databricks-package-management admins MANAGE

databricks secrets put-acl databricks-package-management users READ

Adicionar segredos do repositório Python pacote

Adicione os detalhes do repositório do pacote Python usando os nomes de chave secreta predefinidos, sendo que todos os três campos são opcionais.

# Add index URL.

databricks secrets put-secret --json '{"scope": "databricks-package-management", "key": "pip-index-url", "string_value":"<index-url-value>"}'

# Add extra index URLs. If you have multiple extra index URLs, separate them using white space.

databricks secrets put-secret --json '{"scope": "databricks-package-management", "key": "pip-extra-index-urls", "string_value":"<extra-index-url-1 extra-index-url-2>"}'

# Add cert content. If you want to pip configure a custom SSL certificate, put the cert file content here.

databricks secrets put-secret --json '{"scope": "databricks-package-management", "key": "pip-cert", "string_value":"<cert-content>"}'

Modificar ou excluir segredos privados do repositório PyPI

Para modificar os segredos do repositório PyPI, use o comando put-secret. Para excluir os segredos do repositório PyPI, use delete-secret conforme mostrado abaixo:

# delete secret

databricks secrets delete-secret databricks-package-management pip-index-url

databricks secrets delete-secret databricks-package-management pip-extra-index-urls

databricks secrets delete-secret databricks-package-management pip-cert

# delete scope

databricks secrets delete-scope databricks-package-management