Princípios de orientação do lakehouse

Os princípios orientadores são regras de nível zero que definem e influenciam sua arquitetura. Para criar um data lakehouse que ajude sua empresa a ter sucesso hoje e amanhã, é fundamental que haja consenso entre as partes interessadas de sua organização.

Organize dados e ofereça dados confiáveis como produtos

A curadoria de dados é essencial para criar um data lake de alto valor para BI e ML/IA. Trate os dados como um produto com definição, esquema e ciclo de vida claros. Garanta a coerência semântica e que a qualidade dos dados melhore de camada em camada para os usuários corporativos poderem confiar totalmente nos dados.

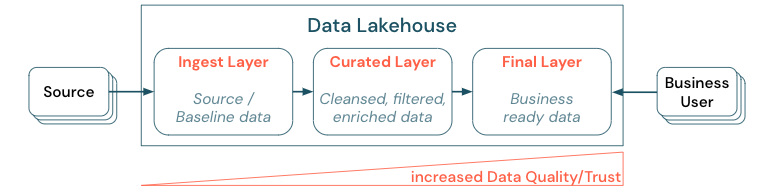

A curadoria de dados por meio do estabelecimento de uma arquitetura em camadas (ou multi-hop) é uma prática recomendada essencial para lakehouse, pois possibilita que as equipes de dados estruturem os dados de acordo com os níveis de qualidade e definam funções e responsabilidades por camada. Uma abordagem comum de camadas é:

Camada de ingestão: Os dados de origem são ingeridos no lakehouse na primeira camada e devem ser mantidos lá. Quando todos os dados downstream são criados a partir da camada de ingestão, é possível reconstruir as camadas subsequentes a partir dessa camada, se necessário.

Camada selecionada: o objetivo da segunda camada é manter dados limpos, refinados, filtrados e agregados. O objetivo dessa camada é oferecer uma base sólida e confiável para análises e relatórios em todas as funções.

Camada final: A terceira camada é criada de acordo com as necessidades do negócio ou do projeto. Apresenta uma visão diferente como produtos de dados para outras unidades de negócios ou projetos, preparando os dados de acordo com as necessidades de segurança (por exemplo, dados anônimos) ou otimizando o desempenho (com visualizações agregadas previamente). Os produtos de dados dessa camada são vistos como a verdade para os negócios.

Os pipelines de todas as camadas precisam garantir que as restrições de qualidade dos dados sejam atendidas, o que significa que os dados devem ser sempre precisos, completos, acessíveis e uniformes, mesmo durante leituras e gravações simultâneas. A validação de novos dados acontece no momento da entrada dos dados na camada selecionada e os passos de ETL a seguir funcionam para melhorar a qualidade desses dados. A qualidade dos dados deve melhorar na medida em que os dados progridem pelas camadas e, como tal, a confiança nos dados aumenta subsequentemente do ponto de vista comercial.

Elimine os silos de dados e minimize a movimentação de dados

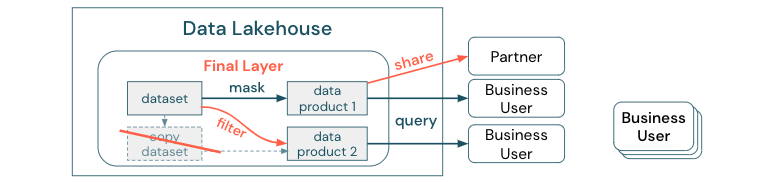

Não crie cópias de um dataset com processos comerciais que dependam dessas cópias diferentes. As cópias podem se tornar silos de dados que ficam fora de sincronia, levando a uma menor qualidade do seu data lake e, finalmente, a insights desatualizados ou incorretos. Além disso, para compartilhar dados com parceiros externos, use um mecanismo de compartilhamento empresarial que permita o acesso direto aos dados de forma segura.

Para deixar clara a distinção entre uma cópia de dados e um silo de dados: uma cópia autônoma ou descartável de dados não é prejudicial por si só. Às vezes, isso é necessário para aumentar a agilidade, a experimentação e a inovação. No entanto, se essas cópias se tornarem operacionais com produtos de dados de negócios posteriores dependentes delas, elas se tornarão silos de dados.

Para evitar silos de dados, as equipes de dados geralmente tentam criar um mecanismo ou pipeline de dados para manter todas as cópias em sincronia com o original. Como é improvável que isso aconteça de forma consistente, a qualidade dos dados acaba se degradando. Isso também pode levar a custos mais altos e a uma perda significativa da confiança do usuário. Por outro lado, vários casos de uso comercial exigem o compartilhamento de dados com parceiros ou fornecedores.

Um aspecto importante é compartilhar de forma segura e confiável a versão mais recente do conjunto de dados. As cópias do conjunto de dados geralmente não são suficientes, pois podem ficar fora de sincronia rapidamente. Em vez disso, os dados devem ser compartilhados por meio de ferramentas de compartilhamento de dados corporativos.

Democratize a criação de valor pelo autoatendimento

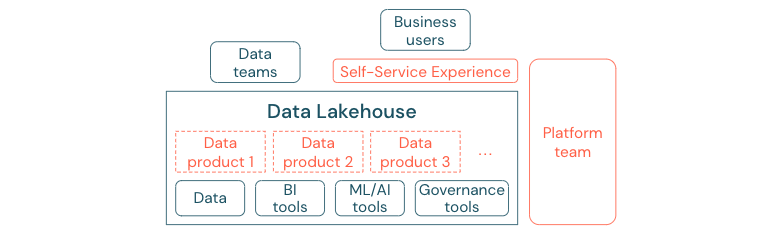

O melhor data lake não pode fornecer valor suficiente se os usuários não puderem acessar facilmente a plataforma ou os dados para suas tarefas de BI e ML/IA. Reduza as barreiras de acesso a dados e plataformas em todas as unidades de negócios. Considere processos enxutos de gestão de dados e forneça acesso de autoatendimento para a plataforma e os dados subjacentes.

As empresas que migraram com sucesso para uma cultura baseada em dados prosperarão. Isso significa que cada unidade de negócios deriva suas decisões de modelos analíticos ou da análise de seus próprios dados ou apresentados de forma centralizada. Para os consumidores, os dados devem ser facilmente detectáveis e acessíveis com segurança.

Um bom conceito para produtores de dados é “dados como produto”: os dados são oferecidos e mantidos por uma unidade de negócios ou parceiro de negócios como um produto e consumidos por outras partes com o devido controle de permissão. Em vez de depender de uma equipe central e de processos de solicitação possivelmente lentos, esses produtos de dados devem ser criados, oferecidos, descobertos e consumidos em uma experiência de autoatendimento.

No entanto, não são somente os dados que importam. A democratização dos dados exige as ferramentas certas para todos poderem produzir ou consumir e entender os dados. Para isso, é preciso que o data lakehouse seja uma plataforma moderna de dados e que a IA apresente a infraestrutura e as ferramentas para criar produtos de dados sem duplicar o esforço de configurar outra pilha de ferramentas.

Adotar uma estratégia de governança de dados e AI em toda a organização

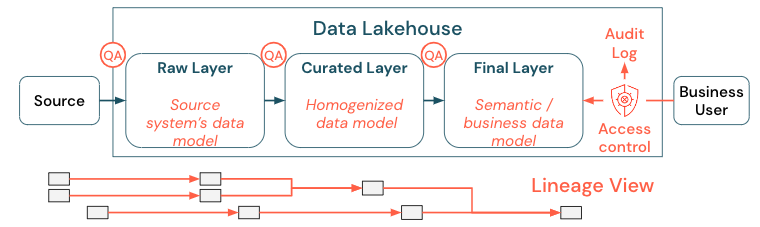

Os dados são um ativo crítico de qualquer organização, mas não é possível dar a todos o acesso a todos os dados. O acesso aos dados deve ser gerenciado ativamente. Controle de acesso, auditoria e rastreamento de linhagem são fundamentais para o uso correto e seguro dos dados.

A governança de dados é um tema amplo. A lakehouse cobre as seguintes dimensões:

Qualidade dos dados

O pré-requisito mais importante para relatórios, resultados de análises e modelos corretos e significativos são dados de alta qualidade. A garantia de qualidade (QA) precisa existir em torno de todos os passos do pipeline. Entre os exemplos de como implementar isso estão: ter contratos de dados, atender aos SLAs, manter os esquemas estáveis e evoluí-los de forma controlada.

Catálogo de dados

Outro aspecto importante é o descobrimento de dados: usuários de todas as áreas de negócios, especialmente em um modelo de serviço, devem ser capazes de descobrir dados relevantes com facilidade. Portanto, um lakehouse precisa de um catálogo de dados que cubra todos os dados relevantes para os negócios. Os objetivos principais de um catálogo de dados são os seguintes:

Assegurar que o mesmo conceito de negócios seja chamado e declarado de maneira uniforme em toda a empresa. Você pode pensar nisso como um modelo semântico na camada curada e na camada final.

Acompanhe a linhagem de dados com precisão para que os usuários possam explicar como esses dados chegaram à forma atual.

Mantenha metadados de alta qualidade, que são tão importantes quanto os próprios dados para o uso adequado dos dados.

Controle de acesso

Como a criação de valor a partir dos dados no lakehouse ocorre em todas as áreas de negócios, o lakehouse deve ser construído com a segurança de um cidadão de primeira classe. As empresas podem ter uma política de acesso a dados mais aberta ou seguir estritamente o princípio dos menores privilégios. Independentemente disso, os controles de acesso aos dados devem estar em vigor em todas as camadas. É importante implementar esquemas de permissão de nível fino desde o início (controle de acesso em nível de coluna e linha, controle de acesso baseado em função ou atributo). As empresas podem começar com regras menos rígidas. Mas, à medida que a plataforma lakehouse cresce, todos os mecanismos e processos de um regime de segurança mais sofisticado já devem estar em vigor. Além disso, todo o acesso aos dados no lakehouse deve ser regido por logs de auditoria desde o início.

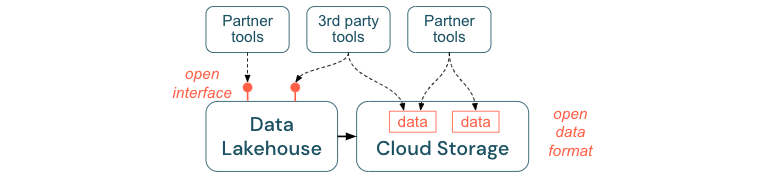

Incentive interfaces abertas e formatos abertos

Interfaces abertas e formatos de dados são cruciais para a interoperabilidade entre o lakehouse e outras ferramentas. Isso simplifica a integração com os sistemas existentes e também abre um ecossistema de parceiros que integraram suas ferramentas à plataforma.

As interfaces abertas são essenciais para possibilitar a interoperabilidade e evitar a dependência de um único fornecedor. Tradicionalmente, os fornecedores criavam tecnologias proprietárias e interfaces fechadas que limitavam as empresas na forma como podiam armazenar, processar e compartilhar dados.

Como a construção baseada em interfaces abertas ajuda a construir para o futuro:

Isso aumenta a longevidade e a portabilidade dos dados para você poder utilizá-los em mais aplicativos e em mais casos de uso.

Abre um ecossistema de parceiros que podem utilizar rapidamente as interfaces abertas para integrar suas ferramentas à plataforma lakehouse.

Finalmente, padronizando os formatos abertos de dados, os custos totais serão consideravelmente menores. É possível acessar os dados diretamente no armazenamento em nuvem sem a necessidade de transferi-los por meio de uma plataforma proprietária que pode gerar altos custos de saída e computação.

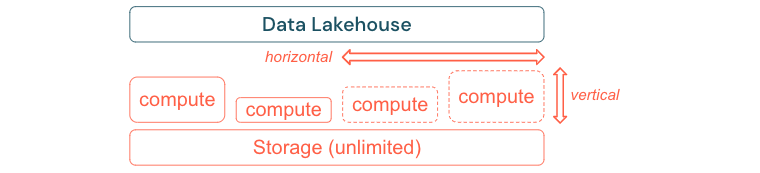

Crie para escalar e otimizar o desempenho e o custo

Os dados inevitavelmente continuam crescendo e ficando mais complexos. Para equipar sua organização para as necessidades futuras, sua lakehouse deve ser capaz de expandir. Por exemplo, você deve ser capaz de adicionar novos recursos facilmente sob demanda. Os custos devem ser limitados ao consumo real.

Geralmente, os processos ETL padrão, os relatórios comerciais e os painéis têm necessidade previsível de recursos em termos de memória e computação. No entanto, novos projetos, tarefas sazonais e abordagens modernas, como o treinamento de modelos (churn, previsão, manutenção), geram picos de necessidade de recursos. Para possibilitar que uma empresa execute todas essas cargas de trabalho é preciso ter uma plataforma escalável em memória e computação. Novos recursos devem ser adicionados facilmente sob demanda e somente o consumo real deve gerar custos. Assim que o pico termina, os recursos podem ser liberados novamente e os custos reduzidos corretamente. Muitas vezes, isso é chamado de dimensionamento horizontal (menos ou mais nós) e dimensionamento vertical (nós maiores ou menores).

O escalonamento também possibilita que as empresas melhorem o desempenho das consultas selecionando nós com mais recursos ou clustering com mais nós. Mas, em vez de sempre fornecerem grandes máquinas e clustering, podem ser provisionamento sob demanda somente pelo tempo necessário para otimizar a relação desempenho/custo geral. Outro aspecto da otimização é o armazenamento versus recursos de computação. Como não há uma relação clara entre o volume de dados e as cargas de trabalho que utilizam esses dados (por exemplo, utilizando apenas partes dos dados ou fazendo cálculos intensivos em pequenos dados), é uma boa prática optar por uma plataforma de infraestrutura que dissocie o armazenamento e recursos de compute.