O escopo da plataforma Lakehouse

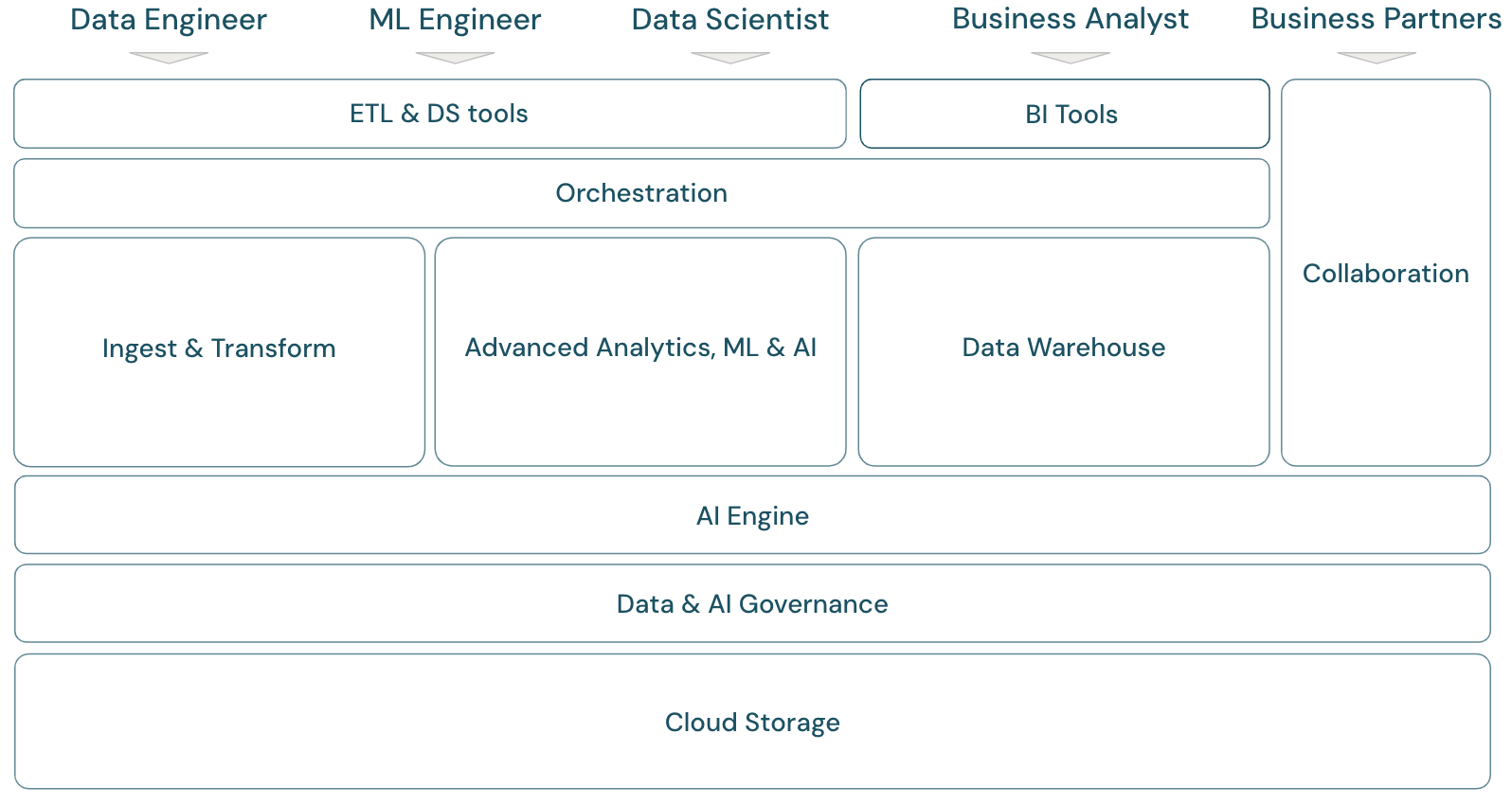

Estrutura de plataforma moderna de dados e IA

Para discutir o âmbito da plataforma de inteligência de dados Databricks, devemos primeiro definir uma estrutura básica para a plataforma moderna de dados e IA:

Visão geral do escopo da lakehouse

A plataforma de inteligência de dados do Databricks abrange toda a estrutura das plataformas de dados modernas. Foi construída na arquitetura lakehouse e conta com a tecnologia de um mecanismo de inteligência de dados que entende as qualidades exclusivas dos seus dados. Atua como base aberta e unificada para cargas de trabalho ETL, ML/IA e DWH/BI e tem o Unity Catalog como principal solução de governança de dados e IA.

Personas da estrutura da plataforma

A estrutura abrange os principais membros da equipe de dados (personas) que trabalham com os aplicativos da estrutura:

Os engenheiros de dados entregam aos cientistas de dados e analistas de negócios dados precisos e reproduzíveis para a tomada de decisões em tempo hábil e insights em tempo real. Eles implementam processos de ETL altamente coerentes e confiáveis para aumentar a confiança do usuário nos dados. Eles garantem que os dados sejam bem integrados aos vários pilares do negócio e, normalmente, seguem as práticas recomendadas de engenharia de software.

Os Cientistas de dados combinam conhecimento analítico e dos negócios para transformar dados em conhecimento estratégico e modelos preditivos. São hábeis na conversão de desafios de negócios em soluções data-driven, seja por meio de conhecimentos analíticos retrospectivos ou modelagem preditiva voltada para o futuro. Utilizando técnicas de modelagem de dados e aprendizado de máquina, projetam, desenvolvem e implantam modelos que revelam padrões, tendências e previsões a partir dos dados. Atuam como uma ponte, convertendo narrativas de dados complexas em histórias compreensíveis, garantindo que as partes interessadas da empresa não somente entendam, mas também possam agir de acordo com as recomendações data-driven, o que por sua vez promove uma abordagem concentrada em dados para a solução de problemas em uma organização.

Os engenheiros de ML (engenheiros de machine learning) lideram a aplicação prática da ciência de dados em produtos e soluções por meio da criação, implantação e manutenção de modelos do machine learning. Seu foco principal está voltado para o aspecto de engenharia do desenvolvimento e implantação de modelos. Os engenheiros de ML garantem a robustez, confiabilidade e escalabilidade dos sistemas de machine learning em ambientes ativos, enfrentando os desafios relacionados à qualidade, infraestrutura e desempenho dos dados. Ao integrar modelos de IA e ML em processos operacionais de negócios e produtos voltados para o usuário, eles facilitam a utilização da ciência de dados na solução de desafios de negócios, garantindo que os modelos não fiquem apenas na pesquisa, mas gerem um valor comercial concreto.

analista de negócios e usuários de negócios: o analista de negócios fornece dados acionáveis às partes interessadas e às equipes de negócios. Eles geralmente interpretam dados e criam relatórios ou outra documentação para a gerência usando ferramentas de BI padrão. Normalmente, eles são o primeiro ponto de contato para usuários comerciais não técnicos e colegas de operações para perguntas rápidas de análise. Os painéis e aplicativos empresariais fornecidos na plataforma Databricks podem ser usados diretamente pelos usuários empresariais.

Os parceiros comerciais são partes interessadas importantes no mundo dos negócios que está, cada vez mais, conectado em rede. São definidos empresas ou indivíduos com os quais uma empresa estabelece um relacionamento formal para atingir um objetivo comum, e podem ter entre eles vendedores, fornecedores, distribuidores e outros parceiros terceirizados. O compartilhamento de dados é um aspecto importante das parcerias comerciais, pois permite a transferência e a troca de dados para melhorar a colaboração e a tomada de decisão baseada em dados.

Domínios da estrutura da plataforma

A plataforma consiste em vários domínios:

Armazenamento: na nuvem, os dados são armazenados principalmente em armazenamentos de objetos dimensionáveis, eficientes e resilientes nos provedores de nuvem.

Governança: recursos relacionados à governança de dados, tais como controle de acesso, auditoria, gerenciamento de metadados, rastreamento de linhagem e monitoramento de todos os dados e ativos de IA.

Mecanismo de IA: o mecanismo de IA oferece recursos de IA generativa para toda a plataforma.

Ingerir & transformar: Os recursos para cargas de trabalho de ETL.

Analítica avançada, ML, e IA: Todos os recursos em torno de machine learning, IA e transmissão analítica.

data warehouse: O domínio que dá suporte aos casos de uso de DWH e BI.

Automação: gerenciamento de fluxo de trabalho para processamento de dados, aprendizado de máquina, pipeline analítico, incluindo suporte para CI/CD e MLOps.

Ferramentas de DS e ETL: as ferramentas de front-end que os engenheiros de dados, cientistas de dados e engenheiros de ML usam principalmente para trabalhar.

Ferramentas de BI: as ferramentas de front-end que os analistas de BI usam principalmente para trabalhar.

Colaboração: recursos para compartilhamento de dados entre duas ou mais partes.

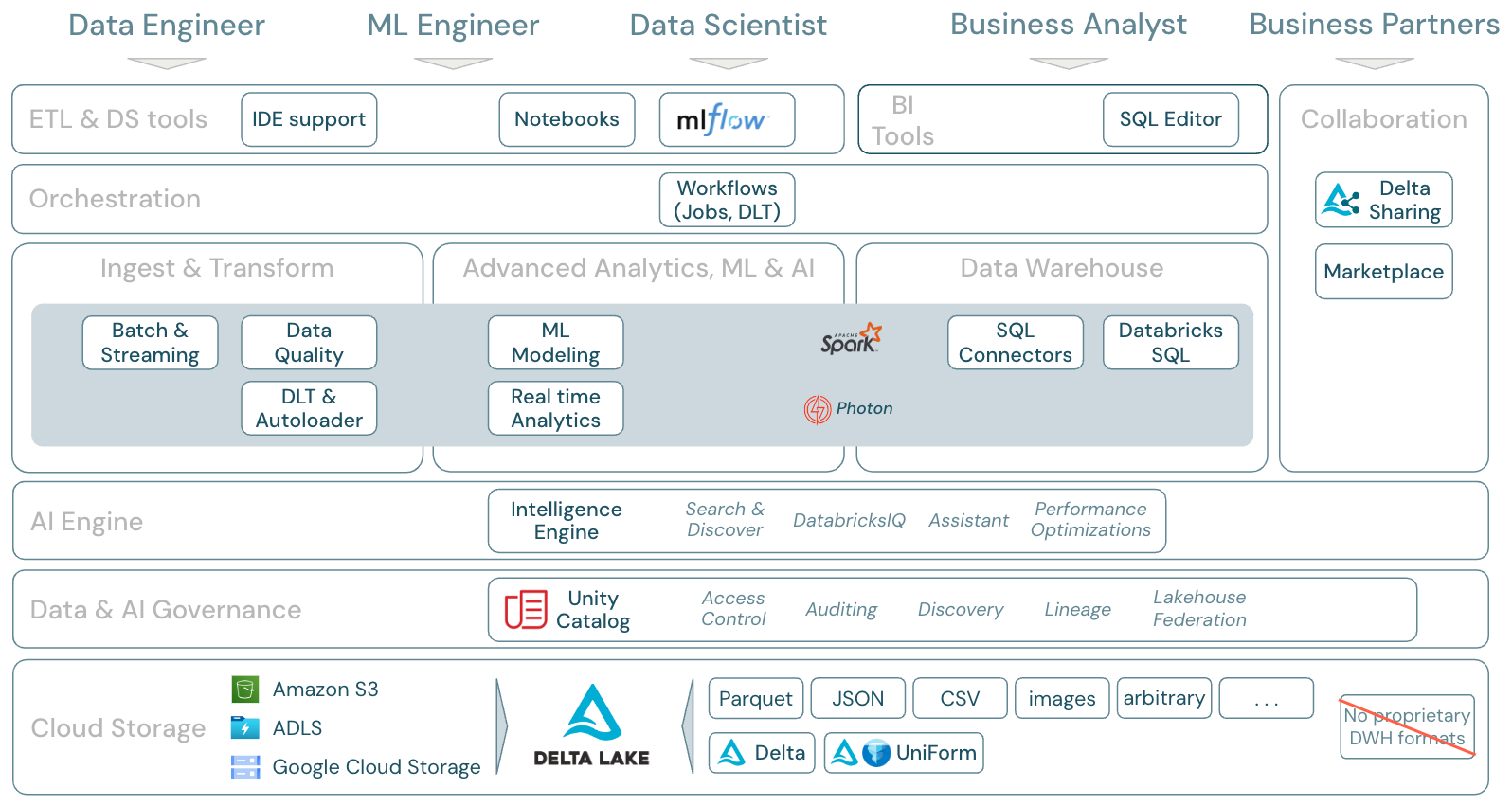

O escopo da Plataforma Databricks

A Databricks Data Intelligence Platform e seus componentes podem ser associados à estrutura da seguinte forma:

Download: escopo da lakehouse - Componentes do Databricks

Cargas de trabalho de dados no Databricks

Ainda mais importante, a Databricks Data Intelligence Platform abrange todas as cargas de trabalho relevantes para o domínio de dados em uma única plataforma, tendo o ApacheSpark/Photon como mecanismo:

Ingestão e transformação

Para ingestão de dados, o Auto Loader processa de forma incremental e automática os arquivos que chegam ao armazenamento em nuvem em trabalhos agendados ou contínuos, sem a necessidade de gerenciar informações de estado. Uma vez ingeridos, os dados brutos precisam ser transformados para estarem prontos para BI e ML/IA. O Databricks entrega recursos poderosos de ETL a engenheiros de dados, cientistas de dados e analistas.

Delta Live Tables (DLT) permite escrever ETL Job de forma declarativa, simplificando todo o processo de implementação. A qualidade dos dados pode ser aprimorada definindo as expectativas dos dados.

Analítica avançada, ML e IA

A plataforma inclui Databricks Mosaic AIUm conjunto de ferramentas de aprendizado de máquina totalmente integradas e AI para máquina clássica e aprendizado profundo. Ele abrange todo o fluxo de trabalho, desde a preparação de dados até a criação de modelos de aprendizado profundo e de aprendizado de máquina, passando Mosaic AI Model Serving pelo.

A Transmissão estruturada do Spark e o DLT possibilitam análises em tempo real.

Data warehouse

A Databricks Data Intelligence Platform oferece também uma solução completa de data warehouse com o Databricks SQL, governada de forma central pelo Unity Catalog com controle de acesso refinado.

Destaque das áreas de recursos do Databricks

Trata-se do mapeamento dos recursos da Databricks Data Intelligence Platform para as outras camadas da estrutura, de baixo para cima:

Armazenamento em nuvem

Todos os dados do site lakehouse são armazenados no armazenamento de objetos do provedor de nuvem. A Databricks é compatível com três provedores de nuvem: AWS, Azure e GCP. Arquivos em vários formatos estruturados e semiestruturados (por exemplo, Parquet, CSV, JSON e Avro), bem como formatos não estruturados (como imagens e documentos), são ingeridos e transformados por meio de lotes ou processos de transmissão.

Delta Lake é o formato de dados recomendado para o lakehouse (transações de arquivos, confiabilidade, consistência, atualizações etc.) e é totalmente em código aberto para evitar o bloqueio. E o Delta Universal Format (UniForm) possibilita a leitura de tabelas Delta com clientes de leitores Iceberg.

Não é utilizado nenhum formato de dados proprietário na Plataforma de inteligência de dados do Databricks.

Governança de dados e IA

Na parte superior da camada de armazenamento, Unity Catalog oferece uma ampla variedade de recursos de governança de dados e AI, incluindo gerenciamento de metadados no metastore, controle de acesso, auditoria, descobrimento de dados e linhagem de dados.

As fontes externas de SQL podem ser integradas ao lakehouse e ao Unity Catalog por meio da federação do lakehouse.

Motor de IA

A Data Intelligence Platform foi desenvolvida com base na arquitetura lakehouse e aprimorada pelo mecanismo de inteligência de dados DatabricksIQ. O DatabricksIQ combina a IA generativa com os benefícios de unificação da arquitetura lakehouse para entender a semântica exclusiva de seus dados. O Intelligent Search e o Databricks Assistant são exemplos de serviços com IA que simplificam o trabalho com a plataforma para todos os usuários.

Orquestração

Databricks Os Jobs permitem que o senhor execute diversas cargas de trabalho para o ciclo de vida completo de dados e IA em qualquer cloud. Eles permitem que o senhor orquestre o Job, bem como Delta Live Tables para os modelos SQL, Spark, Notebook, DBT, ML e outros.

ETL & Ferramentas de DS

Na camada de consumo, engenheiros de dados e engenheiros de ML normalmente trabalham com a plataforma usando IDEs. Os cientistas de dados geralmente preferem notebooks e usam os tempos de execução de ML e IA e o sistema de fluxo de trabalho de machine learning MLflow para rastrear experimentos e gerenciar o ciclo de vida dos modelos.

Ferramentas de BI

Os analistas de negócios normalmente utilizam sua ferramenta de BI preferida para acessar o data warehouse do Databricks. O Databricks SQL pode ser consultado por diversas ferramentas de análise e BI. Consulte BI e visualização

Além disso, a plataforma oferece ferramentas de consulta e análise prontas para uso:

AI/BI Dashboards para arrastar e soltar visualizações de dados e compartilhar percepções.

Especialistas no domínio, como analistas de dados, configuram AI/BI Genie spaces com conjunto de dados, consultas de amostra e diretrizes de texto para ajudar o Genie a traduzir perguntas comerciais em consultas analíticas. Após a configuração, os usuários corporativos podem fazer perguntas e gerar visualizações para entender os dados operacionais.

Editor SQL para analistas SQL analisarem dados.

Colaboração

Delta Sharing é um protocolo aberto desenvolvido pela Databricks para o compartilhamento seguro de dados com outras organizações, independentemente das plataformas de computação que utilizam.

O Databricks Marketplace é um fórum aberto para troca de produtos de dados. Ele aproveita o Delta Sharing para disponibilizar para as empresas de dados as ferramentas necessárias para compartilhar produtos de dados com segurança, além de colocar nas mãos dos consumidores de dados o poder de explorar e expandir seu acesso aos dados e serviços de dados de que precisam.