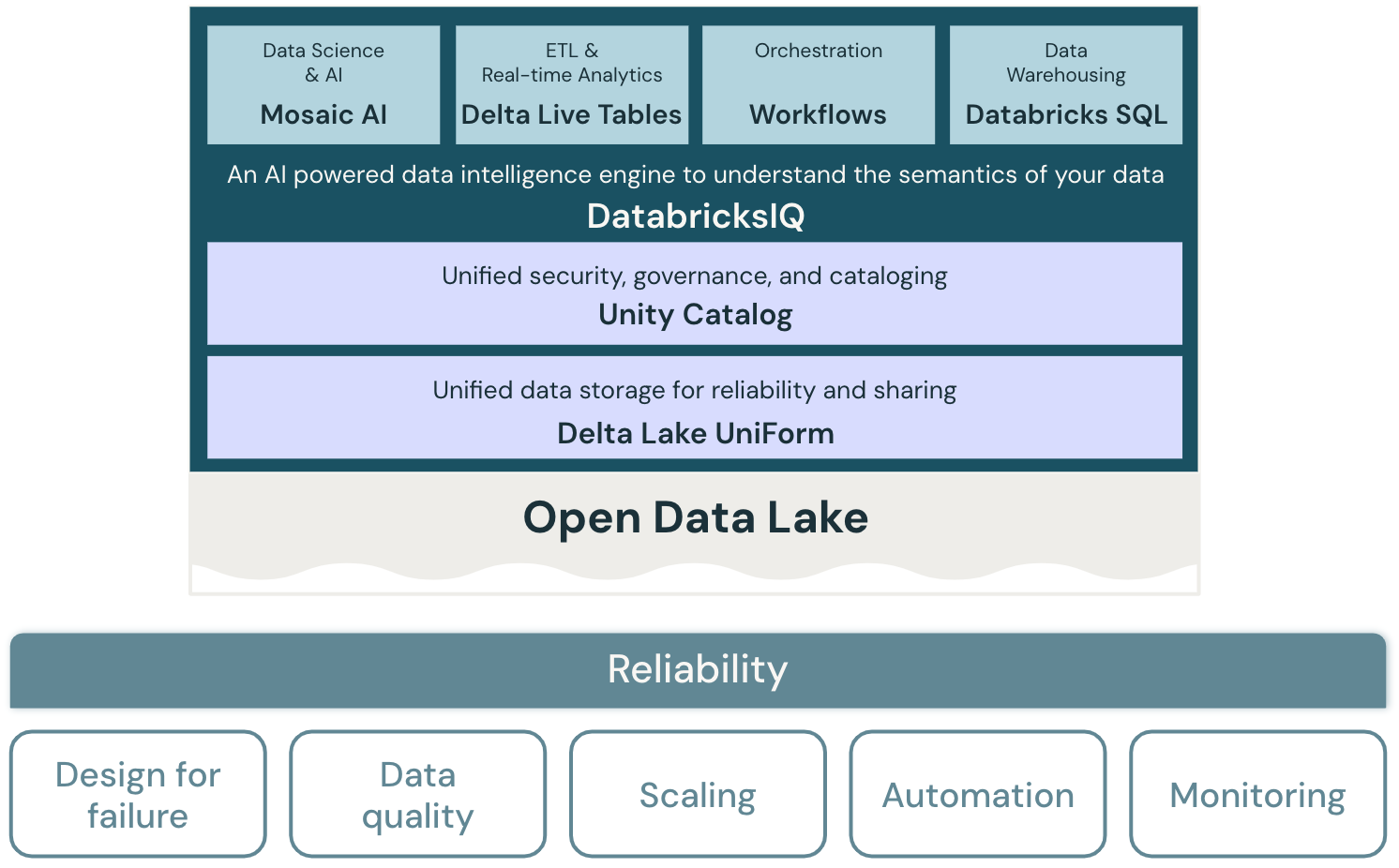

Confiabilidade para o data lakehouse

Os princípios arquitetônicos do pilar de confiabilidade abordam a capacidade de um sistema se recuperar de falhas e continuar funcionando.

Princípios de confiabilidade

Projeto para falha

Em um ambiente altamente distribuído, podem ocorrer interrupções. Tanto para a plataforma quanto para as diversas cargas de trabalho - como Job transmitido, trabalho em lote, treinamento de modelo e query de BI - as falhas devem ser antecipadas e soluções resilientes devem ser desenvolvidas para aumentar a confiabilidade. O foco está em projetar aplicativos para recuperação rápida e, na melhor das hipóteses, automaticamente.

gerencia a qualidade dos dados

A qualidade dos dados é fundamental para obter um entendimento preciso e significativo dos dados. A qualidade dos dados tem muitas dimensões, incluindo integridade, precisão, validade e consistência. Deve ser gerenciado ativamente para melhorar a qualidade dos conjuntos de dados finais para que os dados sirvam como informação confiável e confiável para usuários de negócios.

Design para autoscale

Processos ETL padrão, relatórios de negócios e painéis geralmente têm requisitos de recursos previsíveis em termos de memória e compute. No entanto, novos projetos, tarefas sazonais ou abordagens avançadas, como treinamento de modelo (para rotatividade, previsão e manutenção) criam picos nos requisitos de recursos. Para uma organização lidar com todas essas cargas de trabalho, ela precisa de uma plataforma compute e armazenamento escalonável. A adição de novos recursos conforme necessário deve ser fácil e apenas o consumo real deve ser cobrado. Depois que o pico termina, os recursos podem ser liberados e os custos reduzidos de acordo. Isso geralmente é chamado de dimensionamento horizontal (número de nós) e dimensionamento vertical (tamanho dos nós).

Procedimentos de recuperação de teste

Uma estratégia de recuperação de desastres em toda a empresa para a maioria dos aplicativos e sistemas requer uma avaliação de prioridades, recursos, limitações e custos. Uma abordagem confiável de recuperação de desastres testa regularmente como as cargas de trabalho falham e valida os procedimentos de recuperação. A automação pode ser usada para simular diferentes falhas ou recriar cenários que causaram falhas no passado.

Automatize implantações e cargas de trabalho

A automação de implantações e cargas de trabalho para o lakehouse ajuda a padronizar esses processos, eliminar erros humanos, melhorar a produtividade e fornecer maior repetibilidade. Isso inclui o uso de “configuração como código” para evitar desvios de configuração e “infraestrutura como código” para automatizar o provisionamento de todos os serviços de lakehouse e cloud necessários.

Monitorar sistemas e cargas de trabalho

As cargas de trabalho no lakehouse normalmente integram serviços de plataforma Databricks e serviços externos cloud , por exemplo, como fonte de dados ou destinos. A execução bem-sucedida só pode ocorrer se cada serviço na cadeia de execução estiver funcionando corretamente. Quando esse não é o caso, monitoramento, alerta e registro são importantes para detectar e rastrear problemas e entender o comportamento do sistema.